Dalszy rozwój AI może poważnie zagrozić naszej prywatności, a także bezpieczeństwu. Google ma zamiar przeciwstawić się temu problemowi, oferując serwis z konsultacjami dotyczącymi etycznych sposobów budowania i wykorzystywania modeli sztucznej inteligencji zarówno przez największe, jak i małe przedsiębiorstwa.

Intrygująca propozycja

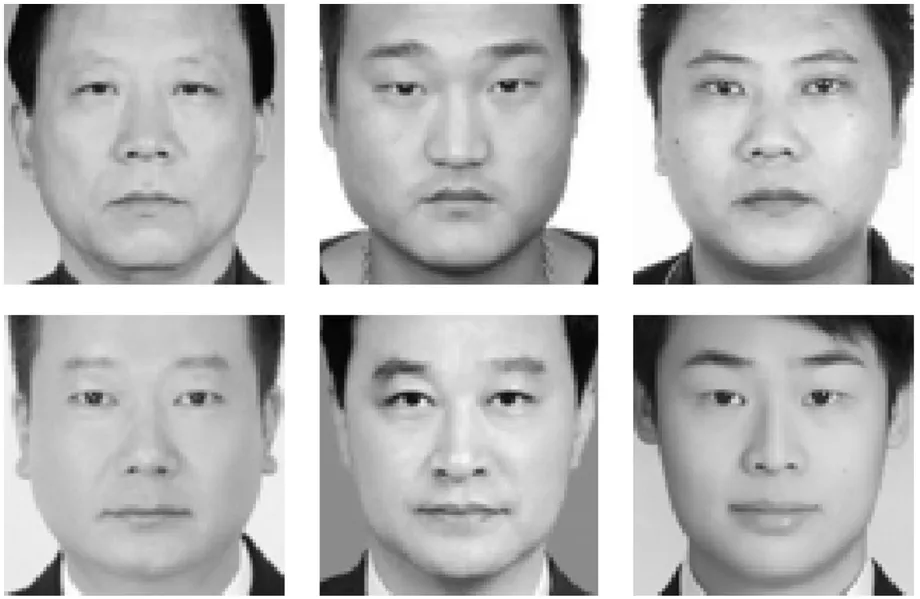

Raporty pokazują, że Google planuje uruchomić ten serwis jeszcze w tym roku. Celem firmy jest wyeliminowanie potencjalnie groźnych czynników, takich jak uprzedzenia rasowe systemów wizji komputerowej, a także ułatwienie dostępu do wiedzy na temat poprawnego, moralnego rozwoju modeli AI. W przyszłości, firma pragnie też nadzorować proces ich tworzenia.

Oczywiście, nie można powiedzieć, że spółka Google sama przestrzega kodeksu moralnego co do joty. Mimo tego, jest bardziej doświadczona w zakresie sztucznej inteligencji, niż wiele mniejszych firm.

Co to może oznaczać?

Jedną możliwością jest plan stworzenia ogólnodostępnego algorytmu, który eliminuje wiele opisywanych problemów, takich jak uprzedzenia rasowe. Jeśli jednak system taki będzie szwankował, wykorzystujące go firmy będą miały na kogo zrzucić winę.

Czy, jeśli Google przebada model AI, który w przyszłości okaże się wadliwy, jego twórcy wciąż ponoszą za niego odpowiedzialność? Tylko czas pokaże.