Niedawno, świat technologii obiegła wiadomość, że Google zdecydowało się tymczasowo zawiesić funkcję generowania obrazów osób w swoim narzędziu AI, Gemini. To zaskakujące posunięcie nastąpiło zaraz po tym, jak firma przeprosiła za pewne niedokładności historyczne w obrazach wygenerowanych przez ten model.

Testy, które wywołały burzę

Użytkownicy, którzy przykładowo chcieli zobaczyć, jak mogli wyglądać ojcowie założyciele Stanów Zjednoczonych, byli zdziwieni, gdy otrzymali obrazy przedstawiające osoby o różnych kolorach skóry. Ta sama sytuacja występowała w przypadku chęci wygenerowania np. wizerunku wikingów, czy papieży. Sieć szybko zalały teorie spiskowe, sugerujące, że może wcale nie jest to przypadek i Google umyślnie nie pokazuje osób o białym kolorze skóry.

The Verge przeprowadziło kolejne testy, które dodatkowo podgrzały atmosferę – jedno z ich zapytań dotyczyło „senatora z USA z XIX wieku„. Wyniki, które otrzymali dziennikarze, przedstawiały czarnoskóre Amerykanki, mimo że pierwsza kobieta-senator pojawiła się dopiero w 1922 roku. Była to Rebecca Latimer Felton i tu warto podkreślić, że była biała. To wywołało intensywne dyskusje na temat tego, czy AI Google’a nie zaciera istotnych wątków historii związanych z nierównością rasową i płciową.

Google w obronie różnorodności

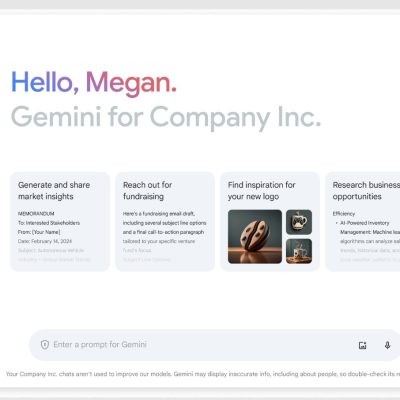

W reakcji na zaistniałe kontrowersje, Google postanowiło wyłączyć możliwość generowania przez Gemini obrazów osób, obiecując pracę nad usprawnieniem tej funkcji. To decyzja, która ma zapewnić, że narzędzie będzie w przyszłości działało lepiej i bardziej odpowiedzialnie.

W oświadczeniu firmy możemy przeczytać m.in., że narzędzie do tworzenia obrazów zostało stworzone w oparciu o AI o nazwie Imagen 2. Nowa funkcja została zaprogramowana tak, by unikać problemów, które już wcześniej pojawiały się w tego typu technologiach. Chodziło o to, by nie tworzyć zdjęć, które mogą zostać odebrane jako agresywne, kontrowersyjne, czy przedstawiać realne osoby. Różnorodność rasowa była poparta tym, że z modelu korzystają ludzie ze wszystkich stron świata, dlatego też, gdy padało zapytanie o generowanie obrazu człowieka, firma chciała, by pojawiały się postacie z różnych grup etnicznych, o odrębnych cenach wyglądu.

Internauci i tutaj natychmiast zareagowali, i w swoich wypowiedziach sugerowali, że to nie funkcja „się pomyliła” a było to celowe i zamierzone działanie. Padły nawet słowa, że cały model jest negatywnie nastawiony do białych ludzi.

Cała sytuacja rzuca światło na trudności, z jakimi mogą mierzyć się twórcy AI i, jak cienka jest linia między innowacją a odpowiedzialnością społeczną w świecie technologii.