Firma Elona Muska, OpenAI, zaprezentowała właśnie swoje najnowsze osiągnięcie. Jest to jej trzeci generator tekstu, adekwatnie nazwany GPT-3. Nie oceniaj książki po okładce – to naprawdę ekscytujące.

GPT-3 już został użyty do automatycznego uzupełniania wyrazów (ang. autocomplete), tworzenia niezwykłych przeglądarek internetowych i ułatwienia stylizowania graficznego stron WWW. Wszystko to dlatego, że program OpenAI rozumie kontekst pomiędzy wyrazami, a co za tym idzie – naszą mowę.

Po kolei

Około roku 2012 nastąpił przełom w przetwarzaniu obrazu przez algorytmy uczenia maszynowego. Przyniosło to wiele zastosowań wizji komputerowej oraz modeli GAN, takich jak autonomiczne samochody i rozpoznawanie twarzy. Specjaliści mówią, że najnowsze osiągnięcie OpenAI w ten sam sposób zrewolucjonizuje przetwarzanie tekstu, przyczyniając się nawet do rozwoju silnej sztucznej inteligencji.

W końcu, czym jest ludzka mowa, jeśli nie bardzo rozwiniętym generatorem tekstu?

GPT to skrót od Generative Pre-trained Transformer, co oznacza generatywny przetrenowany transformator. Jak każdy model AI, szuka on powtarzalnych wzorów w zestawie danych, dzięki czemu może przewidzieć rezultat wprowadzenia nowych, nieznanych dotychczas informacji. Idealnie się to wpasowuje do automatycznego uzupełniania wyrazów w naszych przeglądarkach.

Na przykład, jeśli wpiszesz słowo woda w GPT-3, system ten wie, że bardziej prawdopodobnym następstwem tego wyrazu są mineralna lub gazowana, a nie komputerowa. Dla nas może wydawać się to bardzo proste, ale skąd maszyna miała to wiedzieć?

Jedyny w swoim rodzaju

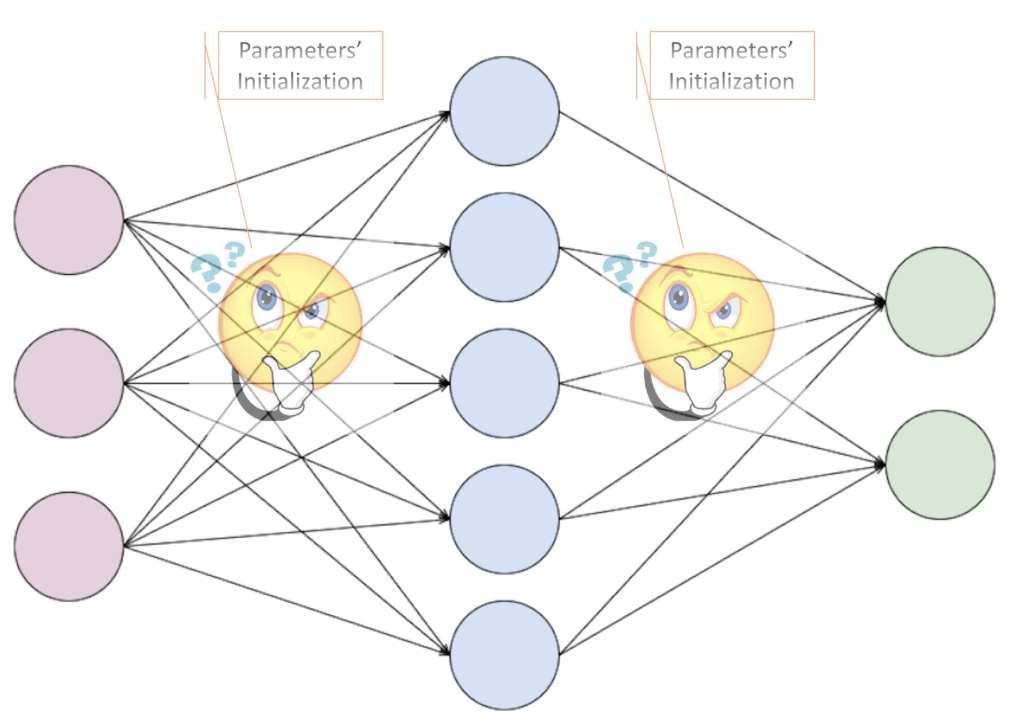

Trzeci model GPT wyróżnia skala, na której operuje. Posiada on aż 175 miliardów parametrów, czyli połączeń pomiędzy neuronami w sieci. Dla porównania, pierwszy z nich, stworzony zaledwie 2 lata temu, dostępnych miał ich 117 milionów. Za to GPT-2, który niezmiernie przyczynił się do rozwoju sztucznej inteligencji, posiadał ponad 100 razy mniej parametrów (1,5 miliarda).

Jedną z limitacji tworzenia AI w dzisiejszych czasach może być brak wystarczająco dużych baz danych. W końcu, więcej danych = lepsze rezultaty. GPT-3 stworzony został jednak z użyciem prawdziwego giganta wśród baz. Nie wiemy dokładnie, jak duża była, lecz szacuje się, że cała angielska Wikipedia, czyli około 6 milionów artykułów, to zaledwie 0,6% z niej.

Zastosowania GPT-3

Z takimi danymi wyniki GPT-3 powinny być równie imponujące. Choć wciąż trudno nam zrozumieć ich skalę, oto kilka z zastosowań, na które już wpadli programiści:

- pytania i odpowiedzi. Wpisujesz pytanie w wyszukiwarkę, lecz zamiast strony internetowej, uzyskujesz kilku zdaniową, dokładną odpowiedź;

- rozmawianie z historycznymi postaciami. Wystarczy ustawić GPT-3 na dane z poszczególnych wypowiedzi i książek danej osobistości, a w teorii będziemy mogli rozmawiać z jej świadomością;

- rozwiązywanie łamigłówek i zagadek słownych. Choć to może mieć mniej zastosowań, to i tak jest wielkim osiągnięciem;

- generacja kodu na podstawie słownego opisu. Patrz: film powyżej;

- odpowiadanie na pytania medyczne. Dodatkowo, podaje mechanizm biologiczny, który za tym stoi;

- powieściopisarstwo. Możemy znaleźć przykłady tutaj;

- układanie nut na gitarę. GPT-3 już wygenerował fikcyjną piosenkę na podstawie zmyślonego autora i nazwy.

GPT-3 jest… ciekawy. I na razie tyle. Sami deweloperzy mówią, że nie jest to jeszcze gotowy produkt i wciąż popełnia błędy, których człowiek nigdy by nie popełnił.

Co ciekawe, w systemie tym, a także w jego poprzedniku, wystarczy zamienić słowa na piksele, a stworzymy model, który potrafi automatycznie uzupełniać… obrazki.

:format(webp):no_upscale()/cdn.vox-cdn.com/uploads/chorus_asset/file/20664548/Screen_Shot_2020_07_29_at_12.41.08_PM.png)

Tylko pomyśleć, co przyniesie GPT-4…