Jeśli obawiacie się o bezpieczeństwo waszych akcesoriów Smart Home, nie mam najlepszych wieści. Badacze odkryli właśnie nową metodę ataku na głośniki z asystentką głosową Amazon Alexa. Polega ona na wywoływaniu komend odtwarzanych z poziomu tego samego urządzenia.

Alexa atakuje sama siebie

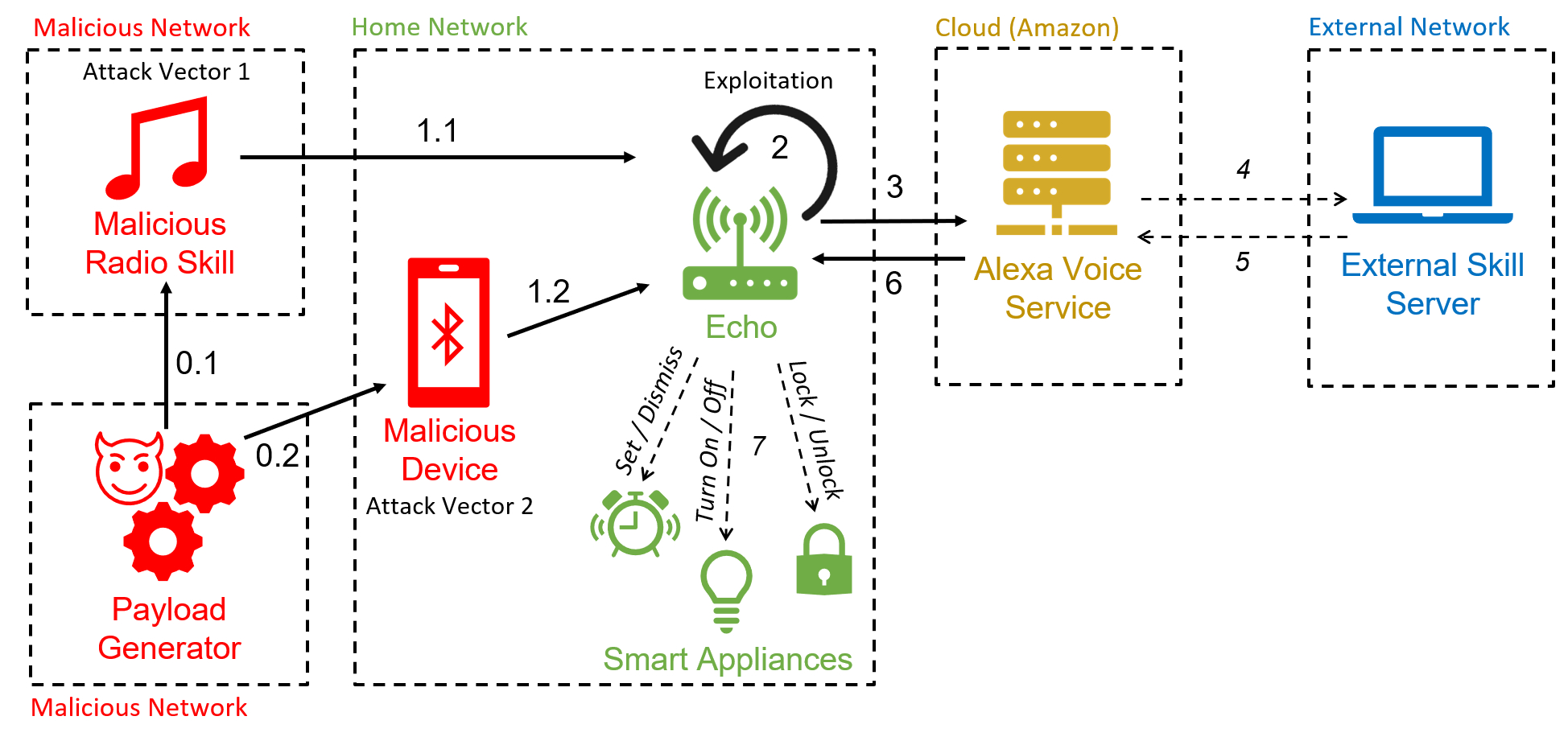

Brzmi to nieco kuriozalnie, ale mniej więcej na tym polega cały atak. Badacze z Uniwersytetu Royal Holloway w Londynie oraz Uniwersytetu w Katanii odkryli sposób na zainfekowanie głośnika z Alexą a następnie wywoływaniu na nim komend głosowych bez udziału użytkownika. Stąd też nazwa – Alexa versus Alexa lub, w skrócie, AvA.

Atak rozpoczyna się od zainfekowania pobliskiego urządzenia wspierającego Bluetooth, które następnie łączy się z głośnikiem. Za jego pomocą możliwe jest odtwarzanie na głośniku komend głosowych wygenerowanych za pomocą syntezatora mowy, na przykład Google Text-to-Speech. Alexa rozpoznaje je w dokładnie taki sam sposób, jak komendy wypowiedziane przez domowników.

By atak przebiegał bez zakłóceń, wykorzystano dodatkowo błąd FVV, czyli Full Volume Vulnerability. Polega on na wywołaniu komend „Echo, wyłącz się” („Echo, turn off”) oraz dowolnej innej komendy, na przykład z zapytaniem o pogodę, w bardzo krótkim odstępie czasu. Powoduje to, że dźwięk odtwarzany z głośnika Amazonu nie jest wyciszany, kiedy Alexa słucha komendy.

Do czego uzyskuje dostęp atakujący? Tak właściwie – do wszystkich komend, jakie mogliby wywołać inni domownicy. Mam tu na myśli zarówno najprostsze pytania o wyszukanie czegoś w internecie, jak również sterowanie urządzeniami Smart Home oraz dokonywanie zakupów na Amazonie.

Badaczom udało się również przeprowadzić bardziej zamaskowany atak, podczas którego uzyskiwali dostęp do systemu głośnika, pozwalając na wprowadzanie komend bez użycia głosu oraz modyfikację odpowiedzi na pytania zadawane przez użytkowników. Odbywało się to za pomocą złośliwych rozszerzeń do asystentki głosowej.

Czy mój głośnik jest narażony na atak AvA?

Odpowiedź na to pytanie brzmi: to zależy. Amazon zapewnia, że naprawił w ostatnim czasie sporo dziur w zabezpieczeniach tych urządzeń oraz aktywnie monitoruje kolejne niepożądane działania związane z atakiem typu AvA.

Dobrą wiadomością, która z pewnością uspokoi wiele osób jest to, że do przeprowadzenia ataku na głośnik najpierw należało zaatakować inne urządzenie, takie jak smartfon, zainfekować je i zmusić do połączenia z głośnikiem Bluetooth. Jak dotąd, nie odnotowano tego typu ataku poza kontrolowanymi warunkami laboratoryjnymi. Warto jest jednak zachowywać podstawowe środki bezpieczeństwa i zawsze uważać na to, w co klikamy w sieci.

Jeśli jednak uważacie, że wasz głośnik Echo Dot mógł paść ofiarą ataku, najszybszym sposobem na jego przerwanie jest zrestartowanie urządzenia. Dla pewności, badacze zalecają jednak przeprowadzenie resetu urządzenia do ustawień fabrycznych w celu pozbycia się złośliwego kodu, który mógł zostać wpleciony w oprogramowanie głośnika.