Sztuczna inteligencja ma moc, ale niedoskonałą. Dowodem na to są liczne grafiki, generowane przez powszechnie dostępne narzędzia. Obecne modele nie zawsze rozumieją wprowadzane przez użytkowników monity, ale naukowcy z BAIR pokazali, jak to zmienić.

Generatory AI zbyt często nie rozumieją monitów

Generatywna sztuczna inteligencja, GPT-4 i stabilna dyfuzja to ostatnio bardzo „modne” tematy. Powstawanie obrazów w oparciu o AI stało się już powszechne, a wiele osób wykorzystuje algorytmy do tworzenia grafik w narzędziach. Mimo to, nadal pojawia się sporo błędów, szczególnie dotyczących niedokładnego podążania za wprowadzanymi przez użytkowników monitami. Rozwiązanie na ten nurtujący problem znaleźli naukowcy z BAIR (Berkeley Artificial Intelligence Research).

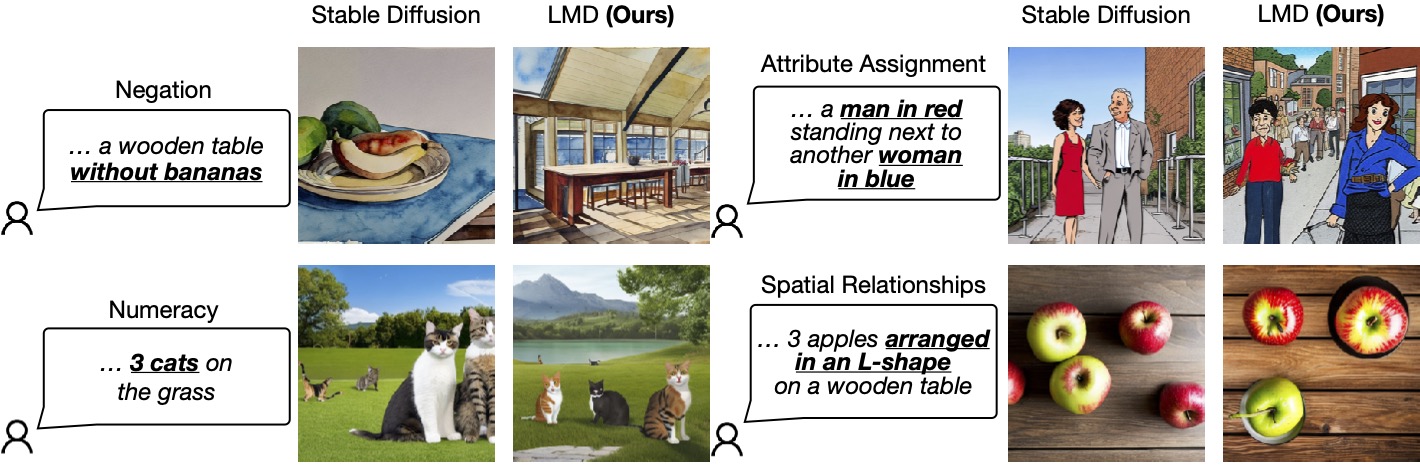

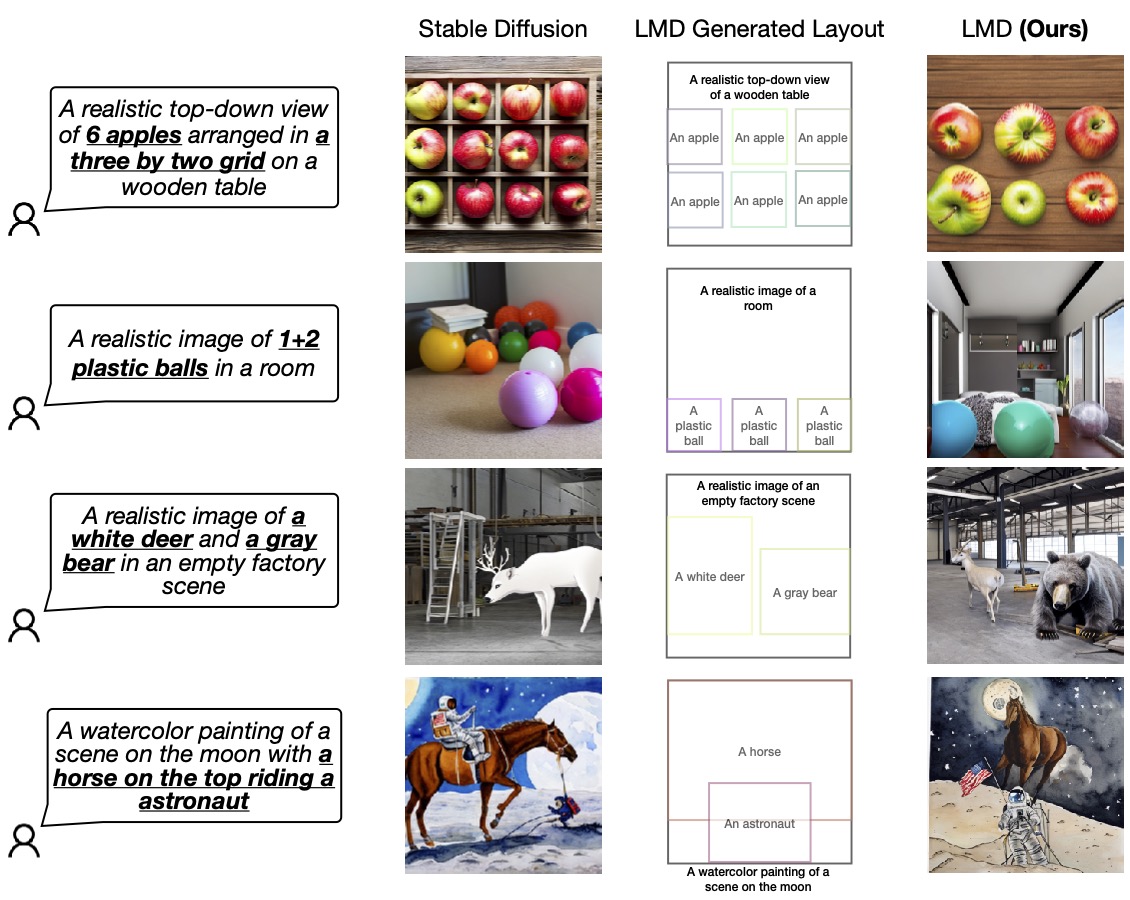

Badacze opracowali poprawkę dla szybkiego rozumienia modeli, działających poprzez generowanie obrazów w monitach tekstowych. Autorzy badania w swoich testach pokazali, jak bardzo niedokładne potrafi być tworzenie obrazów w oparciu o komendę. Dlatego też stworzyli nową metodę dużego modelu językowego (LLM), nazywając go grounded Diffusion (LMD).

W jaki sposób udało się opracować nowy model?

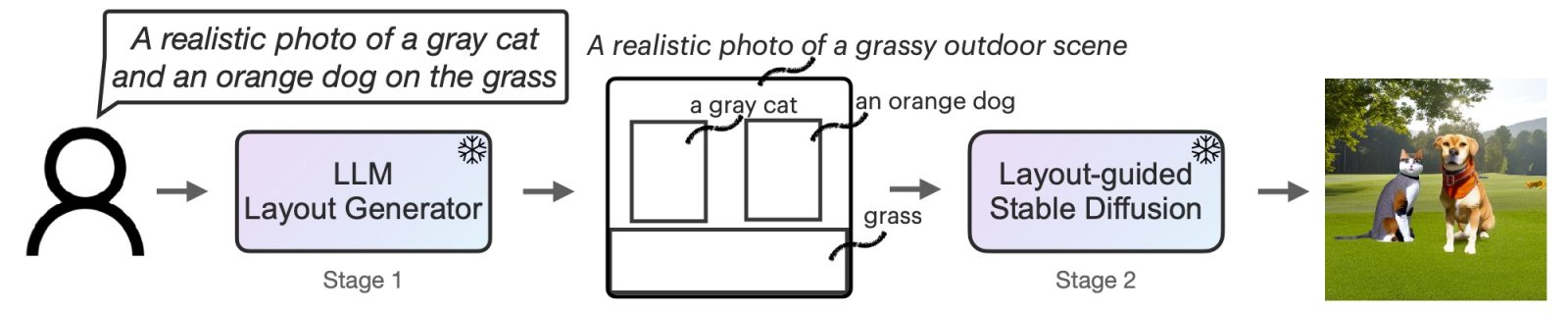

Naukowcy, zamiast wydawać ogromne pieniądze na doszkalanie modeli, postanowili wyposażyć je w ulepszone rozumowanie przestrzenne tak, aby sztuczna inteligencja mogła podejść do swojego zadania nieco bardziej „zdroworozsądkowo”.

W pierwszym etapie badacze dostosowali LLM w taki sposób, by narzędzie było w stanie obeznać się w kontekście, zawartym w monicie. Później z kolei modele dyfuzji mają być sterowane nowo opracowanym kontrolerem.

Co więcej, LMD umożliwia przeprowadzenie dokładniejszej specyfikacji scen, które oparte są na dialogach. Dzięki temu wygenerowane obrazy mogą być zwieńczone wyjaśnieniami, pozwalającymi na wprowadzenie modyfikacji do monitu.

Nowy model pozwala także na wykorzystanie jego szerokich możliwości w dotychczas nieobsługiwanym języku.