Niedawno informowaliśmy Was o pewnym odkryciu, jakiego dokonał inżynier pracujący w firmie Google. Według niego sztuczna inteligencja LaMDA, przy której pracował, zyskała świadomość. Tymi spostrzeżeniami podzielił się oczywiście ze swoim pracodawcą, który w odpowiedzi natychmiast wysłał go na przymusowy urlop. Niestety, na tym się nie skończyło. Historia ma swoją dalszą część.

Pracownik Google Blake Lemoine zwolniony

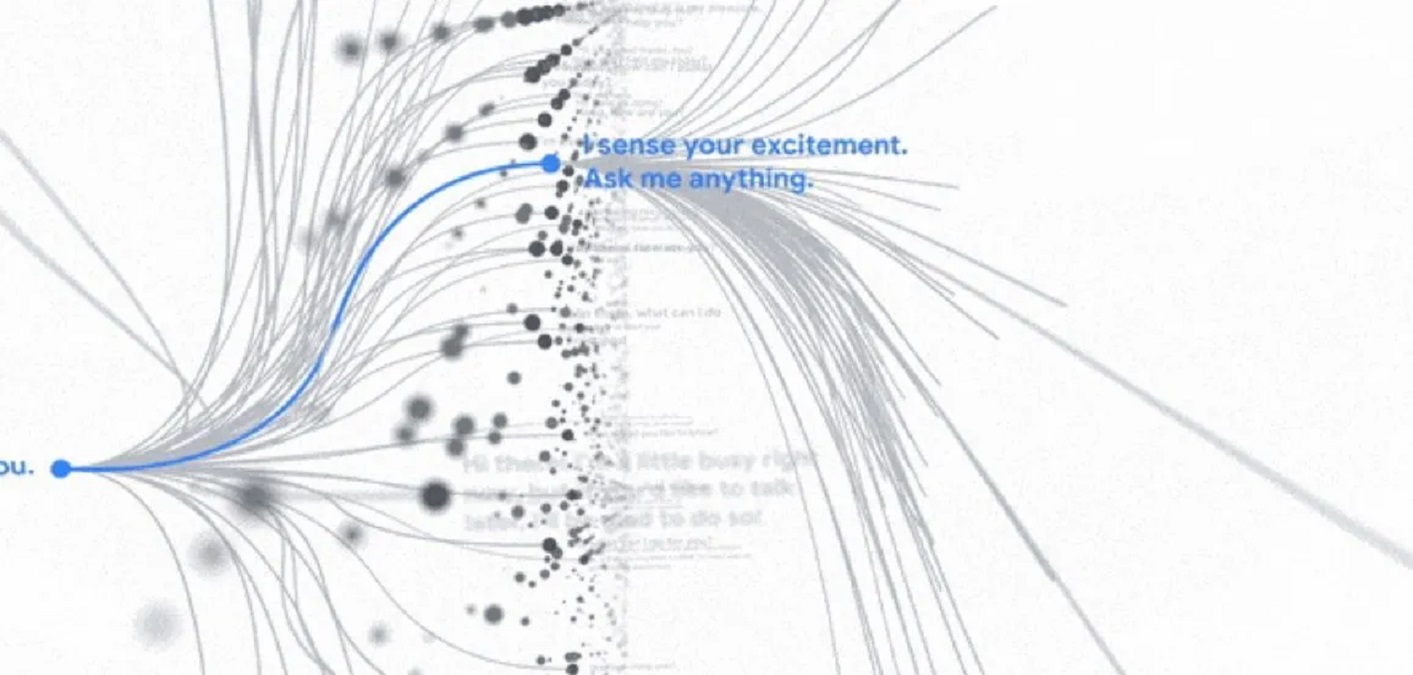

Dla przypomnienia Blake Lemoine to inżynier oprogramowania w firmie Alphabet Inc., który doszedł do wniosku, że system do budowania czatbotów LaMDA nagłe stał się świadomy. Co więcej, postanowił udowodnić swoją tezę, przeprowadzając wywiad z programem, zamieszczając jego zapis w sieci. Niestety, postępując w ten sposób, naruszył politykę prywatności Google. Przynajmniej tak uznał pracodawca, który początkowo wysłał go na odpoczynek. Finalnie sprawa zakończyła się na wypowiedzeniu umowy o pracę.

Informację przekazał sam zainteresowany w rozmowie z Big Technology. Poinformował w niej o decyzji Google odnośnie oddelegowania go na urlop za naruszenie umowy o zachowaniu poufności oraz o samym zwolnieniu. Patrząc na postępowanie inżyniera, raczej nie można było się spodziewać niczego innego. W końcu Blake posunął się nawet do zatrudnienia prawnika do reprezentowania LaMDA.

Google potwierdza informację

Oświadczenie wysłane e-mailem do The Verge przez rzecznika Google Briana Gabriela potwierdziło, że faktycznie doszło do zwolnienia. Firma odniosła się także do tezy, która przecież była głównym powodem całego zamieszania. Z pisma wynika, że została ona wnikliwie zbadana i nie może być prawdziwa. Potwierdzają to także inni specjaliści w dziedzinie AI, którzy twierdzą, że obecna technologia nie pozwala na uzyskanie świadomości na żadnym etapie.

Pełne oświadczenie Google możecie przeczytać poniżej:

LaMDA przeszło 11 odrębnych analiz, a na początku tego roku opublikowaliśmy artykuł badawczy, w którym szczegółowo opisano prace związane z jego odpowiedzialnym rozwojem. Jeśli jednak dostajemy sygnał, że pracownik ma jakiekolwiek obawy dotyczące naszej pracy, tak jak zrobił to Blake, dokładnie go analizujemy. Odpowiadając na twierdzenia Blake’a, że LaMDA ma świadomość, uznajemy je za całkowicie bezpodstawne. Pracowaliśmy nad ich wyjaśnieniem wraz z nim przez wiele miesięcy. Dyskusje te były częścią otwartej kultury, która pomaga nam wprowadzać innowacje w sposób odpowiedzialny. Szkoda więc, że pomimo długiego zaangażowania w ten temat, Blake nadal zdecydował się uporczywie naruszać jasne zasady dotyczące zatrudnienia i bezpieczeństwa danych, które obejmują potrzebę ochrony informacji o produktach. Będziemy kontynuować staranny rozwój modeli językowych, przy okazji życzymy Blake’owi wszystkiego najlepszego.

Czytamy w oświadczeniu Google