Badacze zdołali opracować jeszcze bardziej zaawansowany duży model językowy. GILL, bo o nim mowa, pozwala zarówno odbierać oraz przetwarzać obrazy przesyłane przez użytkownika, jak i generować nowe, które pasują do odpowiedzi.

Obraz jako dana wejściowa i wyjściowa

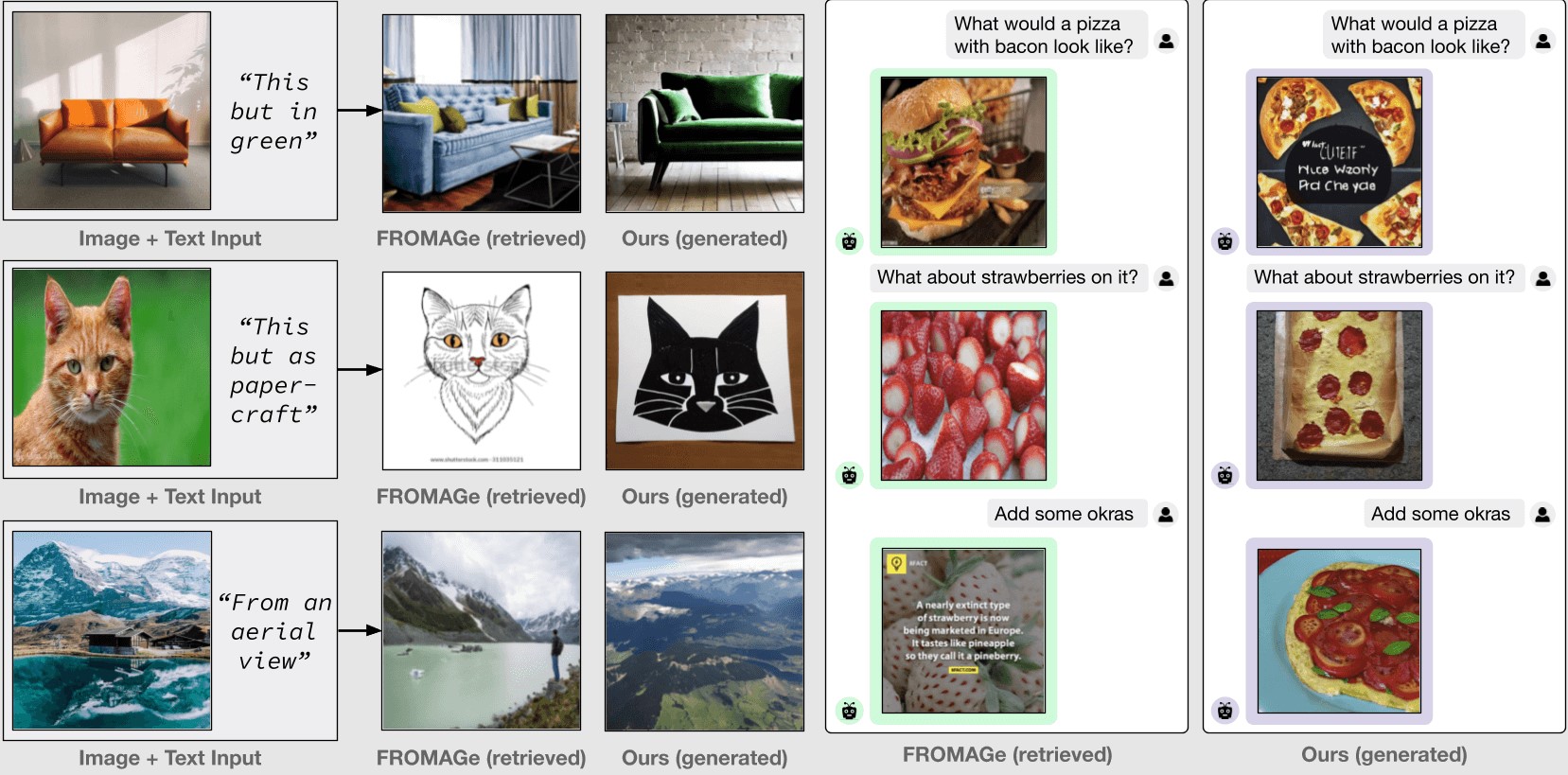

Generatory obrazów i tekstów AI stają się powszechnie dostępne. Choć zdarza się, że ich odpowiedzi są błędne, już coraz częściej bywają bardziej dokładne i spełniają nasze oczekiwania. Jest jednak czynność, której nie potrafią jeszcze sprostać, a mianowicie nie pozwalają na tworzenie grafik po przesłaniu zdjęcia jako danej wejściowej.

Naukowcy z Carnegie Mellon University oraz Language Technologies Institute (LTI), poszukując rozwiązania tego problemu, zdołali opracować multimodalny duży model językowy (LLM). Nazwano go Generowanie obrazów z dużymi modelami językowymi, w skrócie GILL.

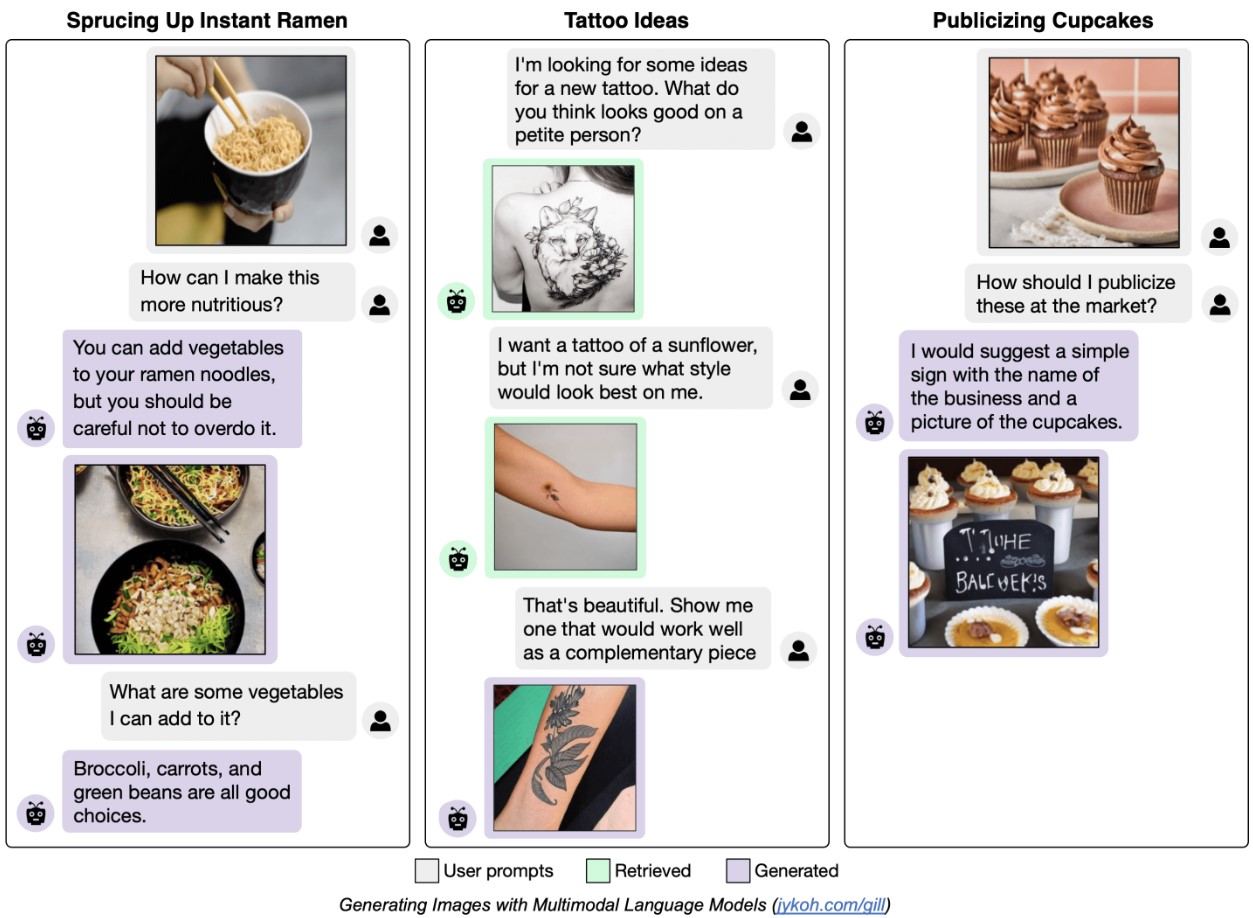

Dzięki niemu użytkownik może nie tylko w odpowiedzi bota otrzymać obraz, ale również go przesłać z konkretnym pytaniem, kierowanym do AI.

Ten nowy model językowy jest w stanie zaakceptować zarówno tekst, jak i obraz, który wprowadzi użytkownik, a następnie wybrać najlepszą metodę odpowiedzi. Poza tym, że może wygenerować opis, jest w stanie również utworzyć obraz, jeśli opcja ta sprawi, że odpowiedź będzie bardziej kreatywna.

Zasada działania nowego modelu AI

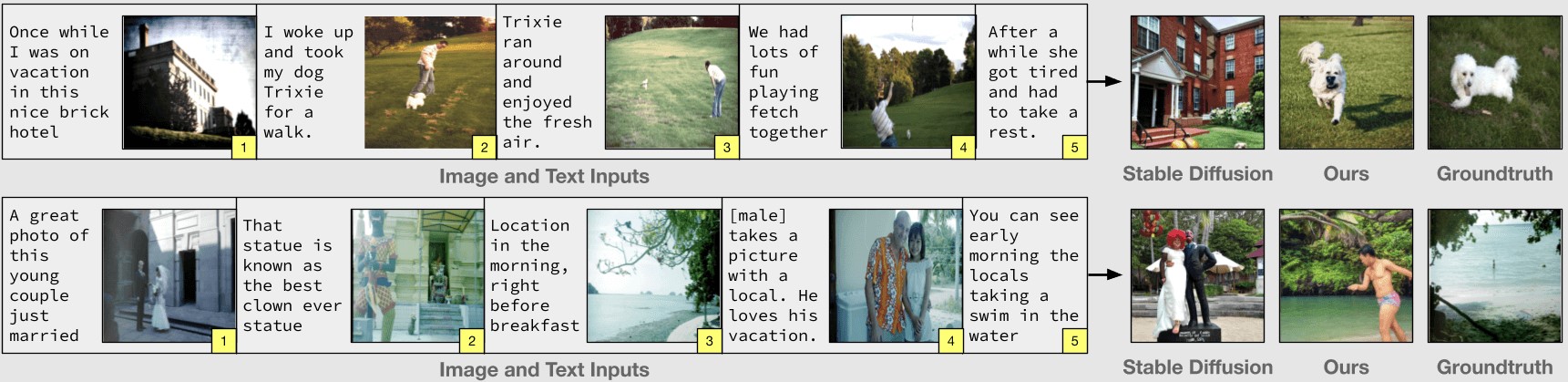

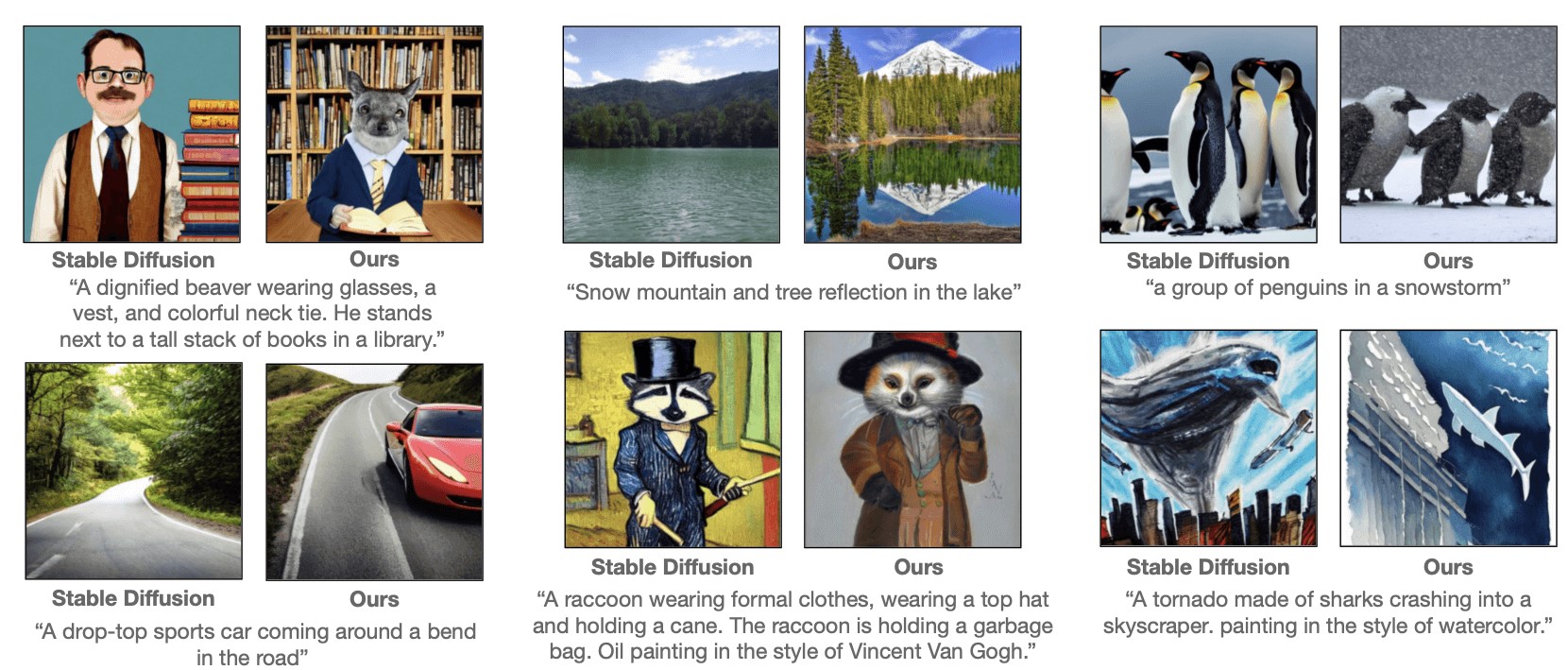

GILL to model pozwalający na przetwarzanie i generowanie warstwowych obrazów oraz tekstu, korzystając z przesłanych przez użytkownika grafik i pytań lub opisów. Aby osiągnąć te umiejętności naukowcy opracowali wydajną sieć mapowania. Metoda ta pozwala na przeszkolenie LLM, który stworzy osadzenia wektorowe pasujące do generatywnego modelu.

Jak twierdzą naukowcy, zdolności nowo opracowanego systemu pozwalają na osiągnięcie szerszego zakresu możliwości pracy, co sprawia, że GILL przewyższa narzędzia, które nie zostały oparte o duże modele językowe. Badacze wierzą w potencjał nowego wynalazku.