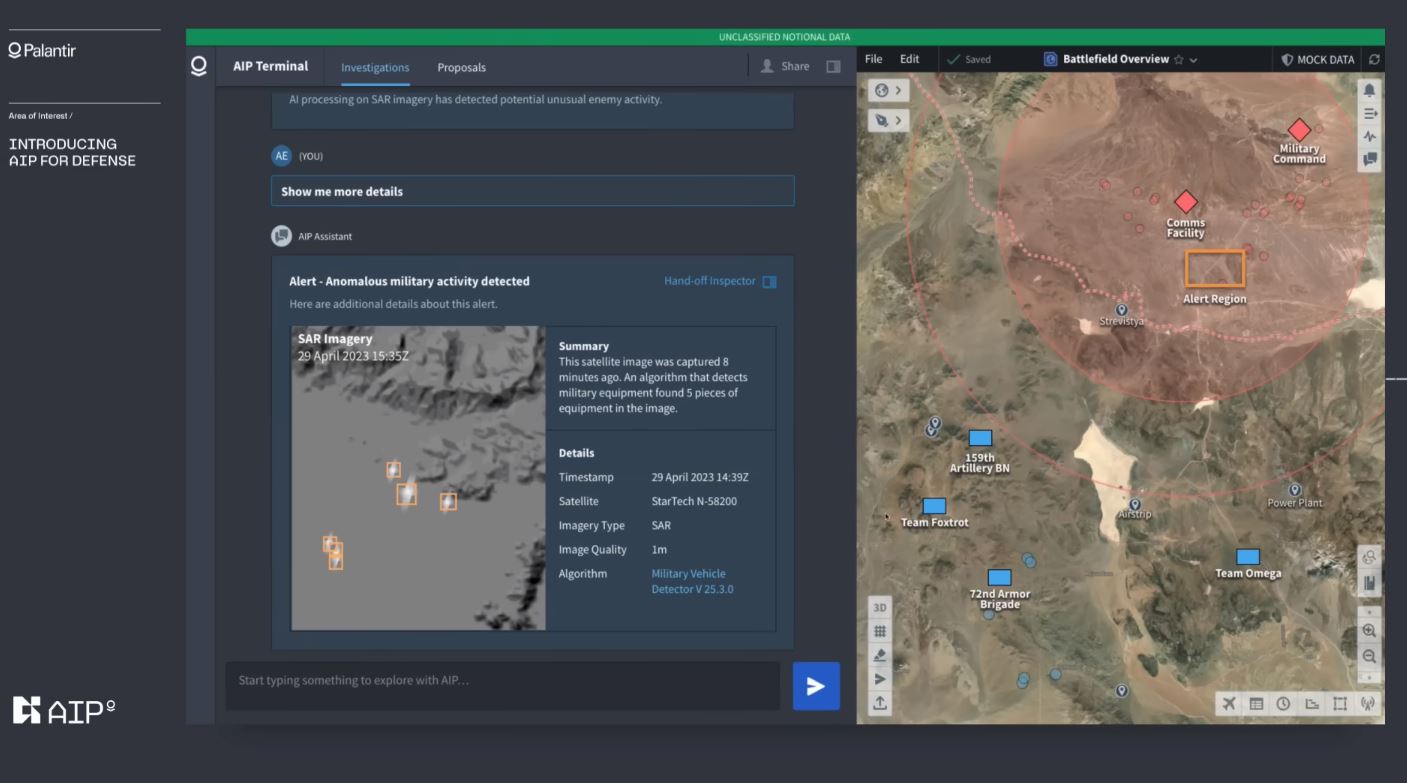

Palantir Artificial Intelligence Platform to system przeznaczony do stosowania na współczesnym polu bitwy. AI pomaga oszacować możliwości wroga oraz sugeruje odpowiednie reakcje.

AI przysługuje się różnym branżom

Kolejne firmy i segmenty klientów odkrywają potencjał drzemiący w narzędziach sztucznej inteligencji. Już nie tylko artyści tworzący grafiki i filmy wideo szeroko wykorzystują algorytmy do kreowania niecodziennych dzieł — roboty w nią wyposażone zyskują inteligencję, biurowi i naukowi asystenci wspierają nas w codziennej pracy a projektanci tworzą z jej pomocą odzież. Gdzie jeszcze można wykrozystać AI? Okazuje się, że sztuczne mózgi znajdą też miejsce… w dowództwie armii.

A to zasługa firmy Palantir, która dostarcza już systemy nadzoru i monitoringu amerykańskim organom imigracyjnym i celnym. Ich najnowszy system, Palantir Artificial Intelligence Platform (AIP), to partner operatorów wojskowych śledzących sytuacje na polach bitew. Firma zaprezentowała demo, w którym AI współpracuje z człowiekiem podczas odkrycia sił wroga w pobliżu granicy. Cyfrowy asystent działający niczym ChatGPT doradza i pomaga rozmieścić drony zwiadowcze, opracowuje taktyczne odpowiedzi na postrzeganą agresję, a nawet organizuje zagłuszanie łączności wroga. System pomaga też oszacować skład i możliwości najeźdźcy oraz sugeruje odpowiednią reakcję w przypadku odkrycia jednostek pancernych.

Czy to najlepszy asystent dowództwa?

Aby zapewnić funkcjonowanie w sposób etyczny i zgodny z prawem, system opiera się na trzech filarach. Po pierwsze — AIP ma być zintegrowany z tajnymi, bezpiecznymi bazami, umożliwiającymi analizowanie w czasie rzeczywistym wrażliwych danych. Drugim filarem jest to, że użytkownicy będą mogli przełączać zakres i działania każdego LLM i zasobu w sieci. Samo AIP wygeneruje bezpieczny cyfrowy zapis całej operacji, kluczowy dla złagodzenia zagrożeń prawnych, regulacyjnych i etycznych we wrażliwych sytuacjach. Po trzecie — najnowocześniejsze zabezpieczenia i reguły działania zapobiegną podejmowaniu przez system nieautoryzowanych akcji.

Demo nie wyjaśnia jednak, w jaki sposób czynnik ludzki zabezpieczy dodatkowo działania systemu ani jakie kroki są podejmowane, aby zapobiec fałszowaniu istotnych faktów i szczegółów przez LLM, na których opiera się system. Nie ujawniono żadnych informacji dotyczących gdzie lub kiedy miałoby rozpocząć się faktyczne wdrożenie systemu.