W ostatnich latach, za sprawą rozwoju platformy ChatGPT firmy Open AI, modele językowe (LLM) zyskały na popularności. Są to zaawansowane algorytmy uczenia głębokiego, które analizują teksty w różnych językach ludzkich, generując realistyczne i wyczerpujące odpowiedzi. Te obiecujące modele przetwarzania języka naturalnego (NLP) stają się coraz bardziej rozpowszechnione, co podkreśla potrzebę oceny ich możliwości i ograniczeń.

AI a analiza sarkazmu

Sarkazm, polegający na przekazywaniu idei poprzez ironiczne stwierdzenie czegoś przeciwnego do zamierzonego przekazu, jest znaczącym wyzwaniem dla LLM. Juliann Zhou, analityk z Uniwersytetu Nowojorskiego, przeprowadziła badanie na temat wykrywania go przez dwa modele językowe. Jej wyniki wskazują na cechy i składniki algorytmiczne, które mogą poprawić zdolności wykrywania sarkazmu przez AI i roboty.

Analizę wykonano w formie badania tekstów publikowanych na platformach społecznościowych lub innych stronach internetowych w celu zrozumienia opinii ludzi na różne tematy. Wiele firm interesuje ta forma sprawdzenia potencjalnych klientów, gdyż może ona pomóc im zrozumieć, jak mogą poprawić swoje usługi i lepiej spełniać ich potrzeby. Modele NLP, które mogą przetwarzać teksty i przewidywać ich podstawowy ton emocjonalny, stają przed wyzwaniem, jakim jest ironia i sarkazm, gdyż często zdarza się im je mylić z pozytywnymi emocjami.

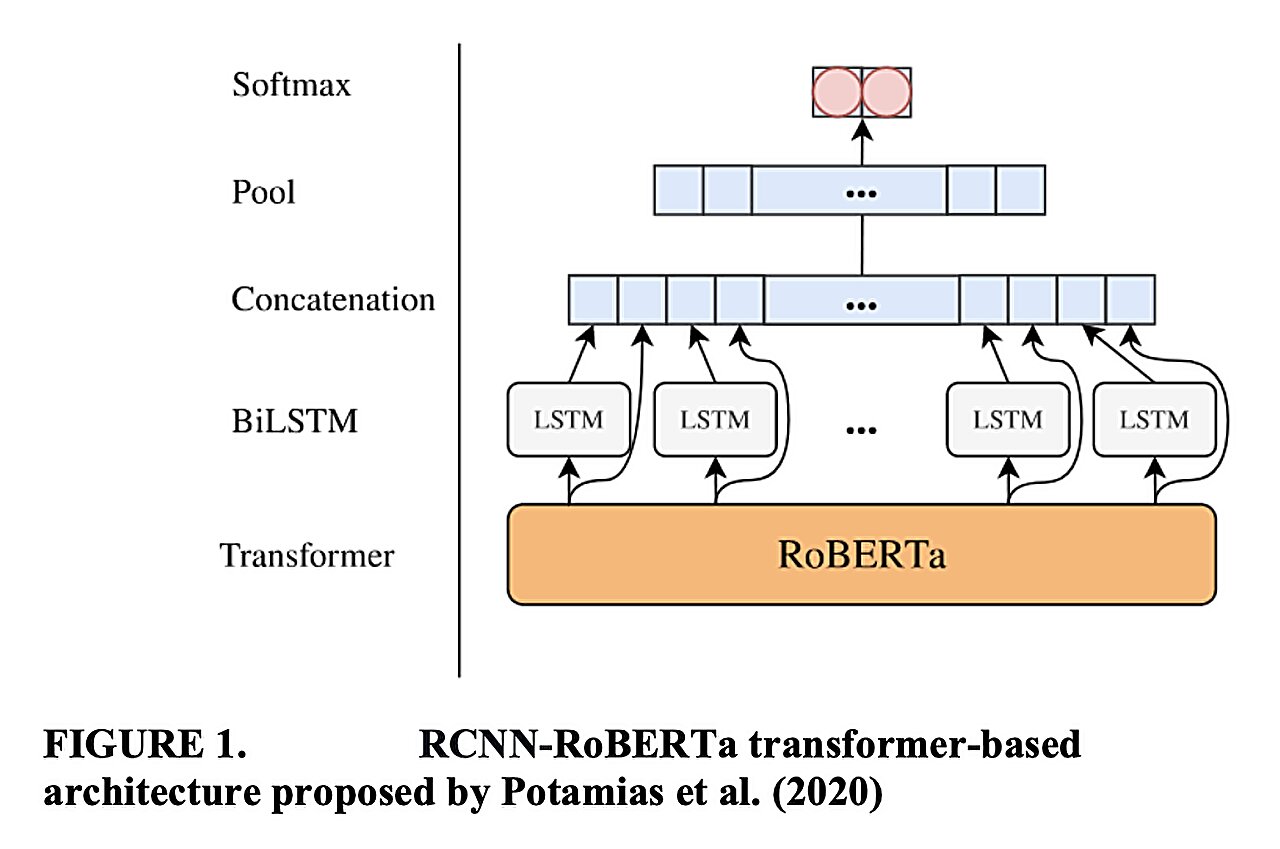

Naukowcy wspólnie opracowali modele, takie jak CASCADE (model kontekstowy analizujący komentarze na Reddit przy użyciu tych dwóch najnowocześniejszych schematów i oceniający ich skuteczność w porównaniu z modelami podstawowymi) i RCNN-RoBERTa (stworzony do uczenia się z nieoznaczonych tekstów poprzez analizowanie tego, co znajduje się w każdej warstwie tekstu), które wykazują obiecujące wyniki w wykrywaniu sarkazmu w tekstach pisanych.

Badanie Zhou wykazało, że uwzględnienie informacji kontekstowych, takich jak osadzenie osobowości użytkownika, może znacznie poprawić wyniki, podobnie jak zastosowanie transformatora RoBERTa w porównaniu z tradycyjnym podejściem CNN. Informacje te mogą wskazywać kierunki przyszłych badań, przyczyniając się do rozwoju LLM, które lepiej wykrywają sarkazm i ironię w języku ludzkim.

Opisane modele mogą w przyszłości być przydatne przy przeprowadzaniu analiz wiarygodności recenzji, postów i innych treści generowanych przez użytkowników. Te badania są kluczowe dla dalszego rozwoju tych technologii, umożliwiając lepsze zrozumienie i interpretację ludzkich emocji przez sztuczną inteligencję.