Sztuczna inteligencja i jej ostatnio silnie rozwijające się narzędzia otwierają przed użytkownikami ogromne możliwości. Poza tym, że AI może wspomagać naszą codzienną pracę, rozrywkę czy podróże, pozwala także na generowanie obrazów, nagrań i dźwięków w oparciu przesłany tekst. To jednak nie oznacza, że sztuczna inteligencja jest nowym „tworem”, który nagle pojawił w tym roku. W jaki sposób rozwinęła się AI?

Początki Google w dążeniu do rozwoju AI

Google, z okazji swoich 25 urodzin, podsumował swoje lata intensywnych prac nad AI. Już od 2001 roku wyszukiwarka giganta z Mountain View działała przy wsparciu prostej wersji systemów uczących się. Jej możliwości sprawiły, że narzędzie to było w stanie tworzyć sugestie poprawek w pisowni, dzięki czemu każdy z użytkowników mógł prawidłowo wpisać tekst, aby skutecznie odnaleźć właściwe informacje.

Tłumacz Google, który pojawił się 5 lat później, czyli w 2006 roku, również korzystał z systemów uczących się. Były one w stanie w sposób automatyczny generować tłumaczenia z języka arabskiego na angielski i odwrotnie. Teraz narzędzie to obsługuje już 133 języki, gromadząc wokół siebie 3 miliardy użytkowników.

Dziewięć lat później, w 2015 roku, technologiczny gigant wprowadził TensorFlow, czyli platformę uczenia maszynowego typu open source. Dzięki temu sztuczna inteligencja od lat może szybciej rozwijać się, stając się narzędziem wspomagającym tworzenie aplikacji obejmujących m. in. rozpoznawanie obrazów, przetwarzanie języka naturalnego czy tłumaczenie maszynowego.

Sztuczna inteligencja w AlphaGo i kolejne małe zwycięstwa AI

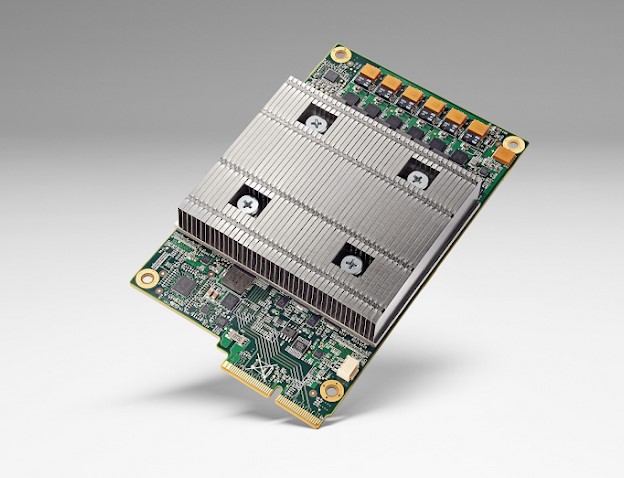

W 2016 roku pierwszy program AI, znany jako AlphaGo, był w stanie pokonać mistrza świata Lee Sedolema w zaawansowanej, złożonej grze planszowej o nazwie Go. W tym samym roku wdrożono też pierwsze jednostki przetwarzania tensorowego (TPU), które odmieniły podejście do uczenia maszynowego, tworząc możliwość szybszego i wydajniejszego rozpowszechniania AI.

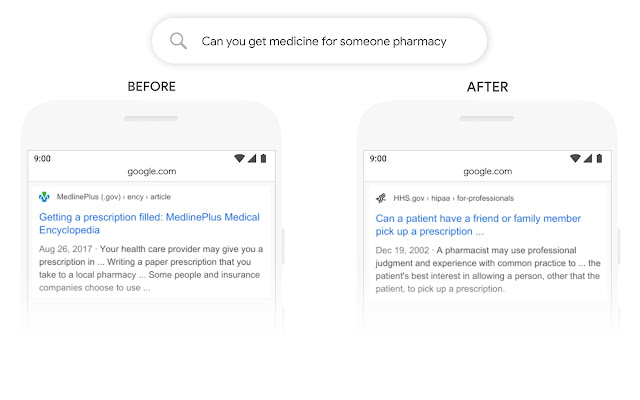

W 2017 roku natomiast wprowadzono nową architekturę sieci neuronowych o nazwie Transformer, wspomagającą rozumienie długich, złożonych zdań. To z kolei otworzyło przez przedsiębiorstwem kolejne możliwości, tym razem na opracowanie BERTa, czyli Bidirectional Encoder Representations from Transformer. Rozwiązanie to jeszcze bardziej ulepszyło możliwości rozumienia tekstu wpisywanego przez użytkowników w wyszukiwarkę.

Rok 2020 stał się przełomowy dla giganta technologicznego w dziedzinie nauki i medycyny. Sztuczna inteligencja Google, zawarta w modelu AlphaFold, pozwoliła na stworzenie 200 milionów struktur białkowych, które wspomogły badaczy w poszukiwaniu metod diagnostycznych.

I wreszcie, 2023 rok stał się istotny w dziedzinie AI, a jego podstawą stał się konwersacyjny duży model językowy LaMDA, opracowany dwa lata temu, oraz PaLM 2. To właśnie dzięki nim możliwe było uruchomienie Barda i rozpowszechnienie generatywnych funkcji w aplikacjach, które każdego dnia są przez nas używane, a więc w Gmailu, Dokumentach, Dysku, Lotach, Mapach oraz serwisie YouTube.