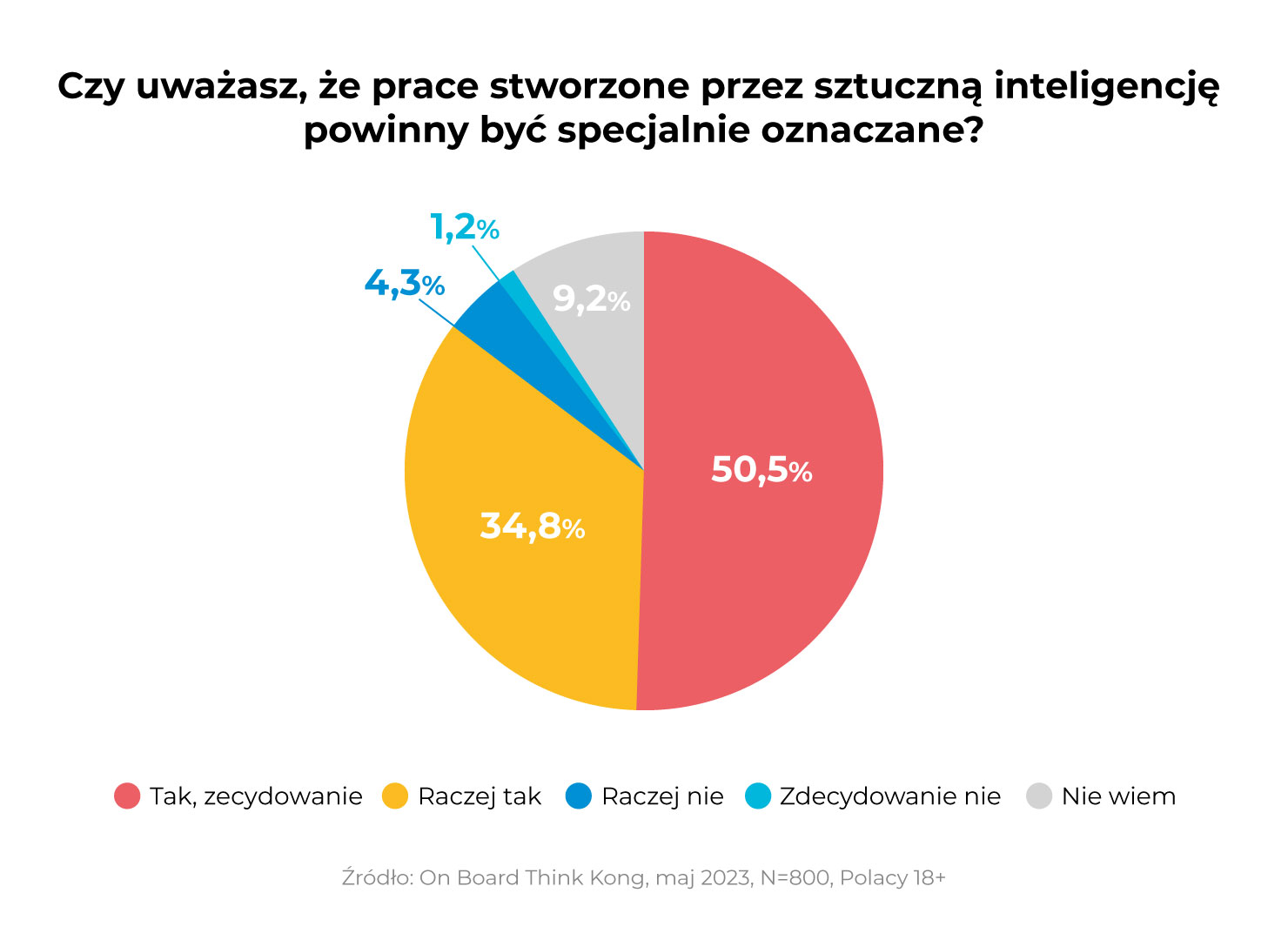

Jedno z najnowszych badań wykazało, że spora część polskich konsumentów chciałaby, aby treści wygenerowane za pomocą narzędzi sztucznej inteligencji były specjalnie oznaczane. Część osób zgłasza także obawy względem treści generowanych przez AI.

Czy oznaczanie AI przy wygenerowanych materiałach jest konieczne?

Jak wynika z badania przeprowadzonego przez agencję doradztwa komunikacyjnego, znanej pod nazwą On Board Think Kong, zdecydowana większość dorosłych Polaków, bo aż 85%, oczekuje tego, aby wyraźnie oznaczać treści generowane przez sztuczną inteligencję. Połowa z badanych, spośród próby zawierającej 800 osób, traktuje to oznaczenie jako zdecydowaną konieczność, a zaledwie 1,2% badanych nie widzi takiej potrzeby.

Coraz więcej użytkowników internetu korzysta z generatorów tekstów AI w postaci np. ChatGPT czy obrazów, wśród których można wymienić Midjourney, Image Creator w Bingu czy Firefly w Adobe. Uzyskane treści są udostępniane i często wykorzystywane w ramach szeroko pojętego marketingu, ale często nie zawierają oznaczenia ich pochodzenia.

Oznaczanie treści w marketingu wymaga regulacji

Póki co, większość firm wręcz chwali się eksploatowaniem potencjału sztucznej inteligencji w licznych narzędziach. Wśród przykładów można wymienić markę Levi’s, która ma zamiar wykorzystywać awatary do promowania swoich nowych kolekcji, zamiast prawdziwych modeli. Jednak z czasem, gdy AI nie będzie już tak zachwycająca i stanie się naszą codziennością, możemy dojść do etapu, gdzie przedsiębiorstwa przestaną ją oznaczać.

Z badań wynika, że sztuczna inteligencja potrzebuje stanowczych regulacji, które będą jasno oznaczały, że udostępniony materiał nie został wytworzony przez człowieka. Sprawą zajmuje się również Unia Europejska, która ostatnio w swojej propozycji rozporządzenia AI Act rozszerzyła listę zakazów. Wśród zabronionych opcji ma pojawić się m. in. kategoryzacja biometryczna na podstawie płci, rasy, narodowości, obywatelstwa, wyznania, pochodzenia etnicznego czy poglądów politycznych.